250x250

반응형

Notice

Recent Posts

Recent Comments

Link

| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | ||||

| 4 | 5 | 6 | 7 | 8 | 9 | 10 |

| 11 | 12 | 13 | 14 | 15 | 16 | 17 |

| 18 | 19 | 20 | 21 | 22 | 23 | 24 |

| 25 | 26 | 27 | 28 | 29 | 30 | 31 |

Tags

- grad-cam

- integrated gradient

- tensorflow text

- login crawling

- 유튜브 API

- correlation

- API

- hadoop

- gather_nd

- TensorFlow

- requests

- session 유지

- 상관관계

- subdag

- spark udf

- chatGPT

- Counterfactual Explanations

- 공분산

- GCP

- top_k

- Airflow

- Retry

- airflow subdag

- API Gateway

- flask

- BigQuery

- XAI

- UDF

- GenericGBQException

- youtube data

Archives

- Today

- Total

데이터과학 삼학년

Dropout 본문

반응형

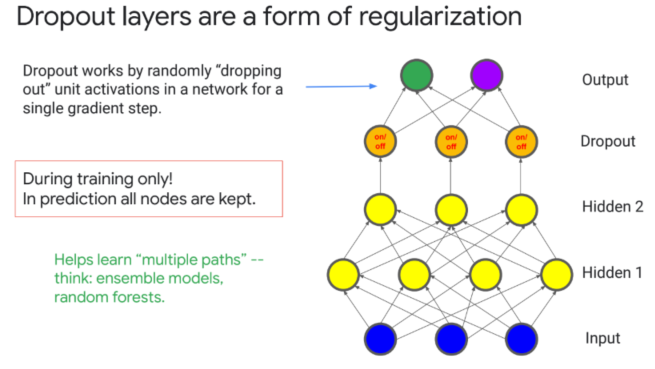

Dropout

- randomly 하게 node(neuron)를 제거 하면서 학습하여 앙상블 효과와 overfitting을 막음

> 특정 경로로 weight가 치중되는 문제를 막음

> 앙상블 러닝으로 볼 수 있음 → random forest의 경우, 트리를 여러번 타면서 overfitting을 방지하는 것과 비슷한 원리

- train 단계에서는 사용하지만 test단계에서는 dropout을 실행하면 안돼!!!

- 일반적으로 0.2를 적용하여 80%의 뉴런을 사용함

> 학습이후에는 학습된 수치에 드랍아웃된 비율만큼 나눠줌 → 드랍아웃 비율 만큼 weight가 과다 산정되었을 것이기 때문

728x90

반응형

LIST

'Machine Learning' 카테고리의 다른 글

| Custom Estimator, Keras (0) | 2020.01.18 |

|---|---|

| Hyperparameter Tuning (1) | 2020.01.18 |

| Optimization (0) | 2020.01.18 |

| Learning rate and Batch size (0) | 2020.01.18 |

| Regularization (0) | 2020.01.18 |

Comments