| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | 6 | 7 |

| 8 | 9 | 10 | 11 | 12 | 13 | 14 |

| 15 | 16 | 17 | 18 | 19 | 20 | 21 |

| 22 | 23 | 24 | 25 | 26 | 27 | 28 |

- requests

- correlation

- XAI

- 상관관계

- tensorflow text

- youtube data

- chatGPT

- GenericGBQException

- grad-cam

- Airflow

- top_k

- TensorFlow

- integrated gradient

- Counterfactual Explanations

- subdag

- API

- gather_nd

- airflow subdag

- flask

- Retry

- 유튜브 API

- UDF

- GCP

- API Gateway

- hadoop

- BigQuery

- spark udf

- login crawling

- 공분산

- session 유지

- Today

- Total

데이터과학 삼학년

Going Faster and Deeper 본문

Going Faster and Deeper

- 하드웨어의 성능을 높인다 → tpu를 사용할 경우, 메모리증대로 인해 좀 더빠를 수 있음

- inceptionnet, alexnet 등 을 통해 convolution의 성능이 입증됨

> 네트워크의 깊이가 깊어질수록 더욱 더 좋은 효과가 나고 있음

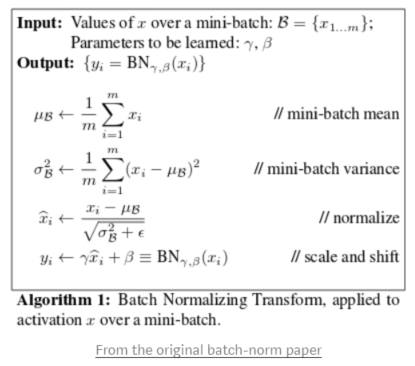

- batch normalization → hidden layer가 많이 적용될 때 계산된 양이 폭발할 수 있음

> batch nomarlization은 -1 ~ 1 사이의 값으로 스케일링함

- 학습속도가 빨라지게 하는 역할을 함

> standard scale로 가는데 스케일된 값에서 shift값과 scale을 맞춰주는 값을 적용함

감마 : scale, 베타 : shift

- activation 함수에 들어가기 전에 normalization의 과정을 거친다음 들어가게 구성

|

활성화 함수가 시그모이드 함수일 때 평균이 0, 분산이 1로 데이터를 고정시키면 활성화 함수를 통과한 값들은 거의 대부분 시그모이드 함수의 직선(선형) 부분에 머물게 된다. 비선형성이 거의 사라진 것이다. 이런 문제를 없애기 위하여 정규화된 데이터에 위와 같이 고유한 확대(scale, γ)와 이동(shift, β) 변환을 수행한다. 확대 인자(γ)와 이동 인자(β)는 역전파에 의해 학습된다. |

- batch normalization에서 scaler를 robust scaler로 쓰면 어떻게 되는가?

> 아마 q1, q3의 값이 변동이 커서 조금 힘들것 같음

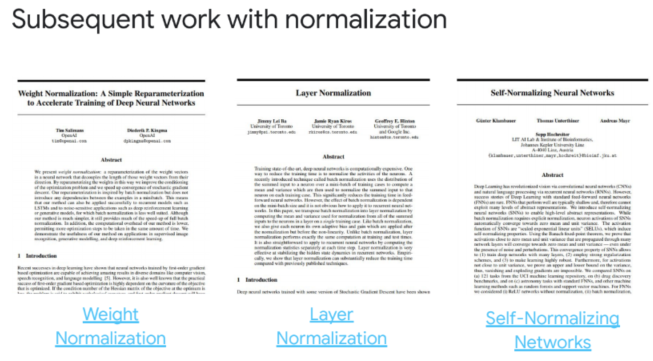

- 다양한 normalization 방법이 있음

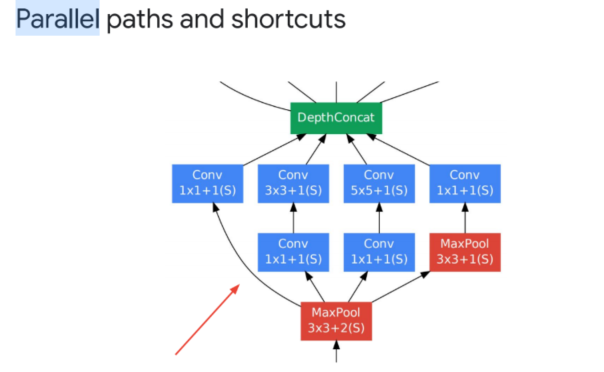

- 더 많은 layer가 오히려 error를 늘렸다는 실험 결과가 있음

> 아마 vanishing gradients 때문일 수 있음

: 구글넷은 이와 같은 문제를 풀기위해 병력 연결과 shortcut 을 적용

: 위와 같은 구조를 반복 시킴

: resnet은 residual이 더작아지는 것들 더해서 → 기존에 비해 얼마나 변했는지를 보게 함

AI accelerators

- GPU, TPU, CPU 등이 있고 결국은 GCP 써서 이런것들 조절해서 쓰면 된다라는 것

- TPU를 쓰려면 doptimizer를 CrossShardOptimizer를 쓰면 됨

- TPUEstimator 가 따로 있음

'Machine Learning' 카테고리의 다른 글

| Speech to text (Speech Recognition API and PyAudio library) (0) | 2020.06.18 |

|---|---|

| Sequence Model (RNN, LSTM) (1) | 2020.06.02 |

| Dealing with Data Scarcity (0) | 2020.06.02 |

| Image Classification (Linear, DNN, CNN) (0) | 2020.06.02 |

| Graph 기초 (0) | 2020.06.02 |